Объем данных, необходимый для обучения GPT: что важно учитывать?

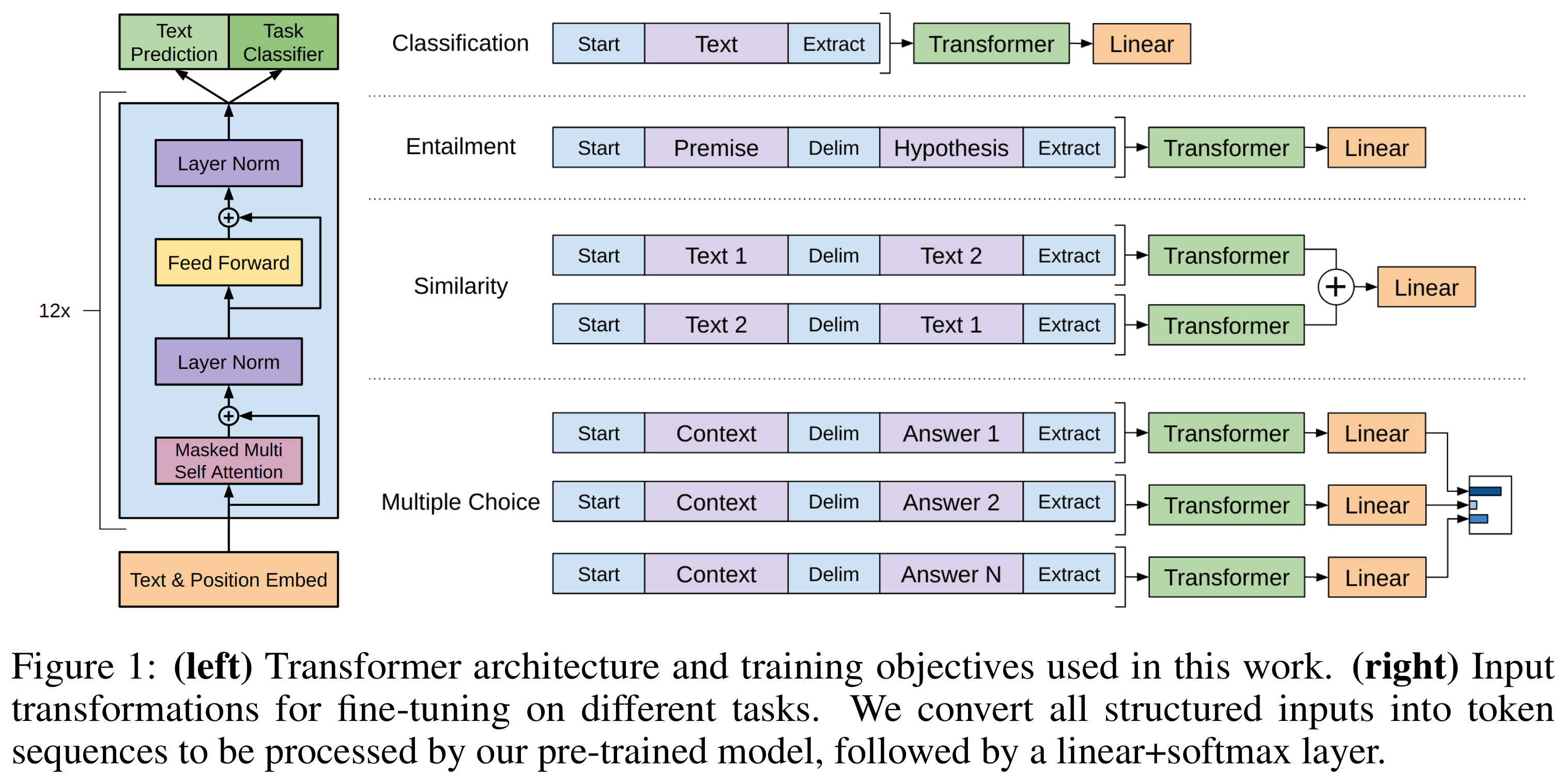

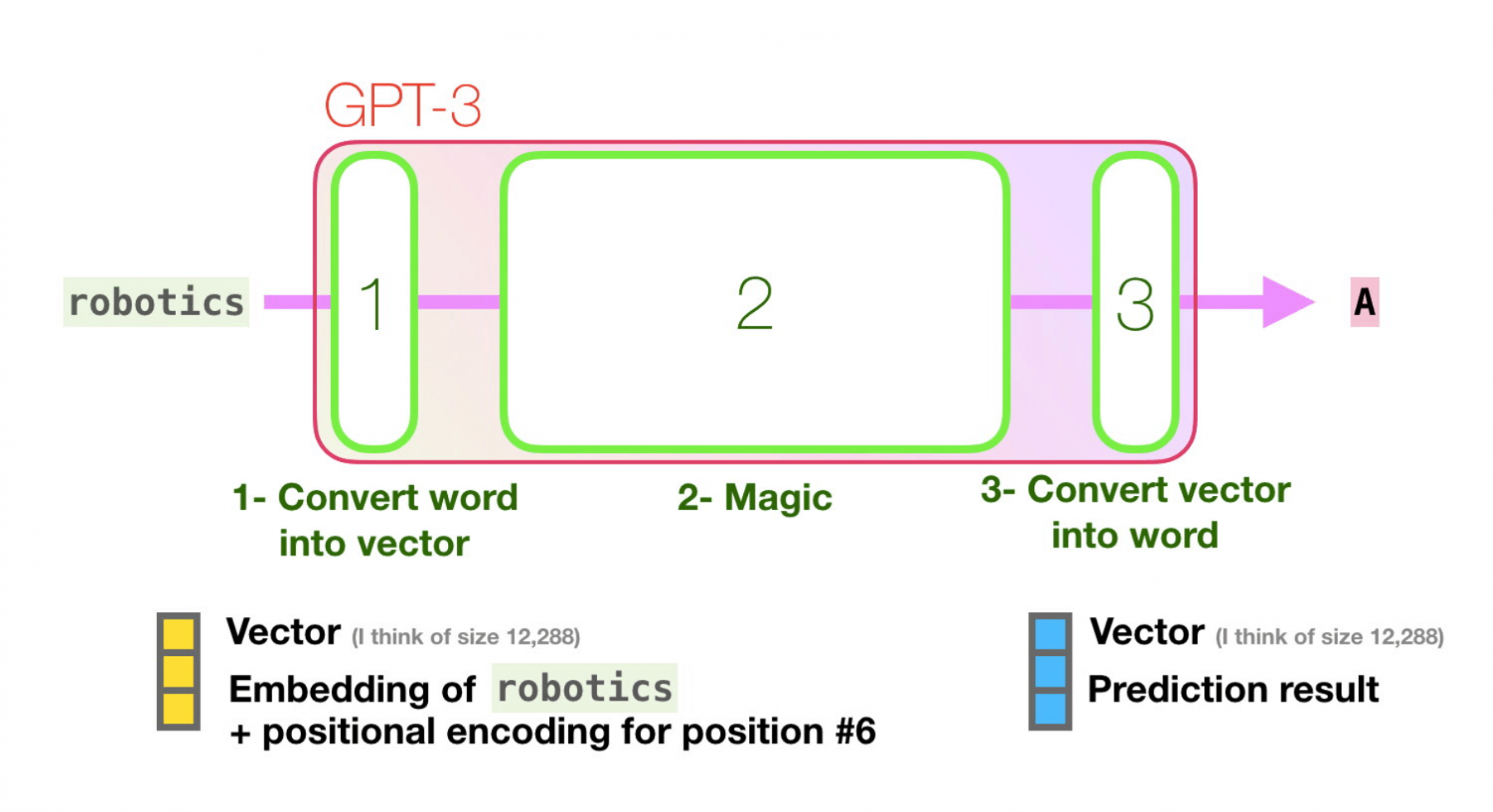

Для успешного обучения модели GPT необходимо учитывать объем и разнообразие данных. Чем больше информации и примеров получает модель, тем более точными и разнообразными становятся её ответы. Однако слишком большой объем данных может привести к излишнему обучению и снижению производительности. В этом разделе мы рассмотрим, сколько данных требуется для создания качественной модели и какие факторы стоит учитывать при подготовке данных.

Для обучения GPT необходимы миллионы текстовых примеров, но их разнообразие важнее объема.

OpenAI Embeddings and Vector Databases Crash Course

При обучении модели важно учитывать не только количество, но и качество данных. Лучше меньше, но точных примеров.

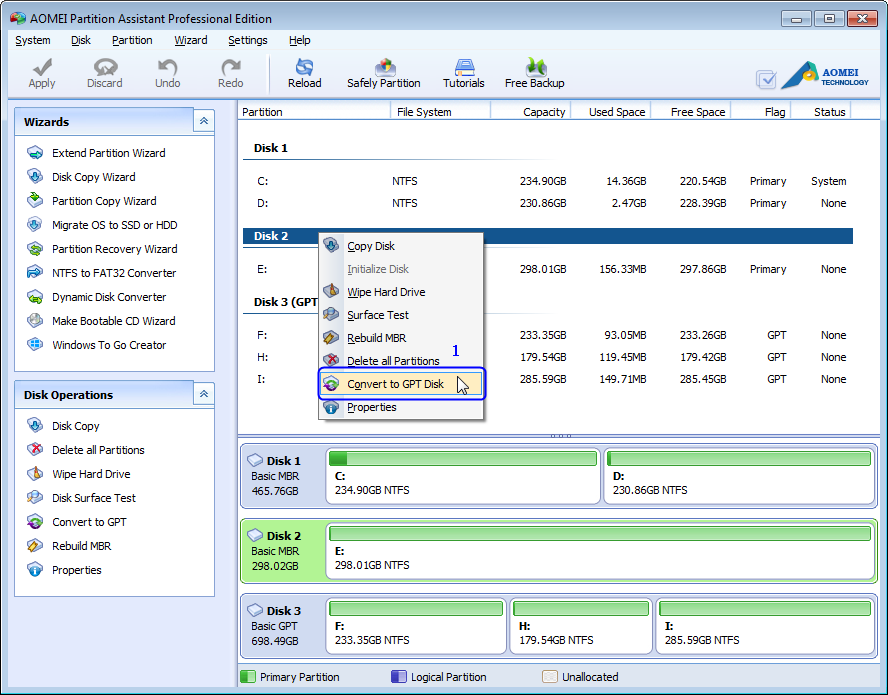

\

Чем более разнообразные источники данных используются для обучения, тем более универсальной будет модель.

🚀 Data Cleaning/Data Preprocessing Before Building a Model - A Comprehensive Guide

Необходимо уделить внимание балансировке данных, чтобы модель не обучалась только на одном типе информации.

Train ChatGPT On Your Data (Easy Method)

Использование разнородных данных помогает модели обучаться на различных стилях письма и контекстах.

Stable Diffusion explained (in less than 10 minutes)

Объем данных влияет на время обучения модели — чем больше данных, тем дольше происходит процесс.

Для эффективного обучения GPT могут быть полезны данные, содержащие как тексты, так и изображения или аудио (в случае мультимодальных моделей).

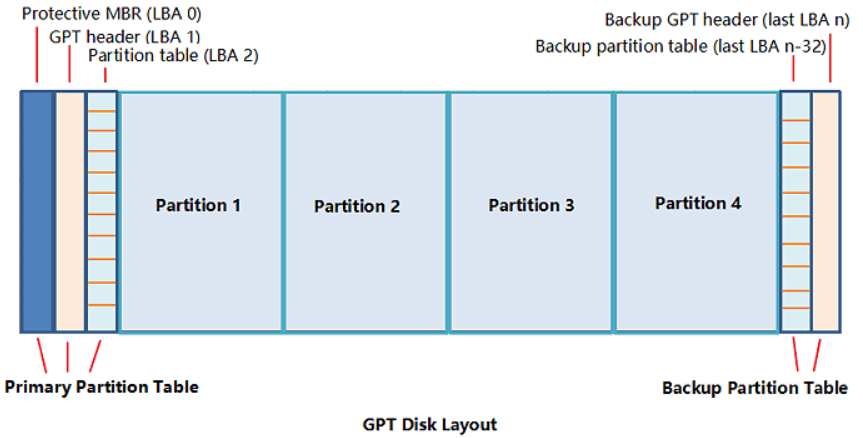

Большое количество данных требует мощных вычислительных ресурсов, таких как кластеры серверов или облачные платформы.

How much training data does a neural network need?

Нужно помнить, что с увеличением объема данных увеличивается и риск зашумления модели избыточной информацией.

Chat with Multiple PDFs - LangChain App Tutorial in Python (Free LLMs and Embeddings)

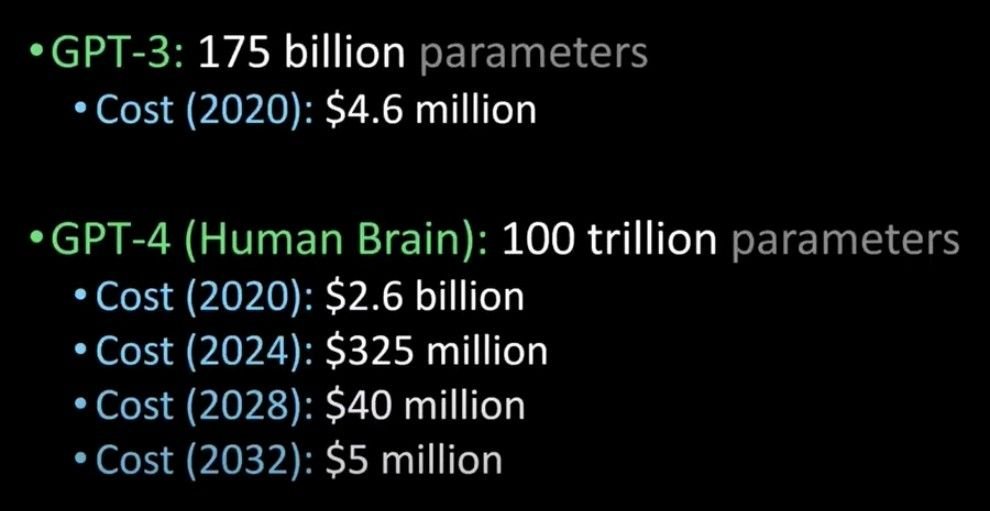

Обычно, для достижения хороших результатов достаточно от 10 до 100 миллиардов слов для обучения GPT-модели.

The Mathematics of Machine Learning