Градиентный спуск: как оптимизировать процессы с помощью этого метода

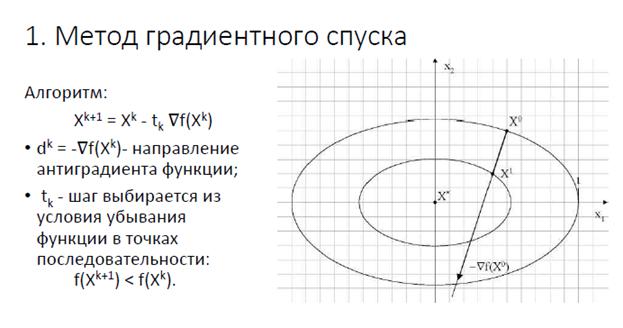

Метод градиентного спуска — это один из самых эффективных алгоритмов для минимизации функции потерь в задачах машинного обучения и оптимизации. Он используется для нахождения оптимальных параметров модели, улучшая результаты обучения и ускоряя процесс. В этой подборке мы рассмотрим принципы его работы, а также полезные советы, которые помогут вам эффективно применить метод на практике.

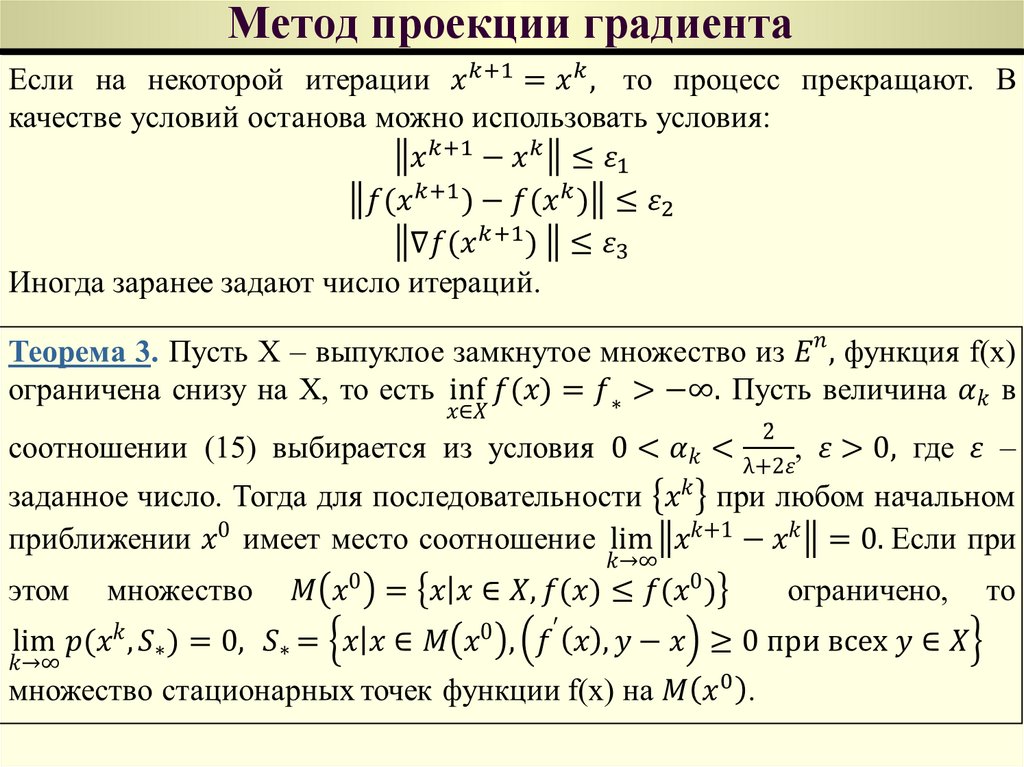

Для успешного применения метода градиентного спуска важно правильно выбрать шаг обучения (learning rate). Слишком высокий шаг может привести к нестабильности, а слишком низкий — к медленной сходимости.

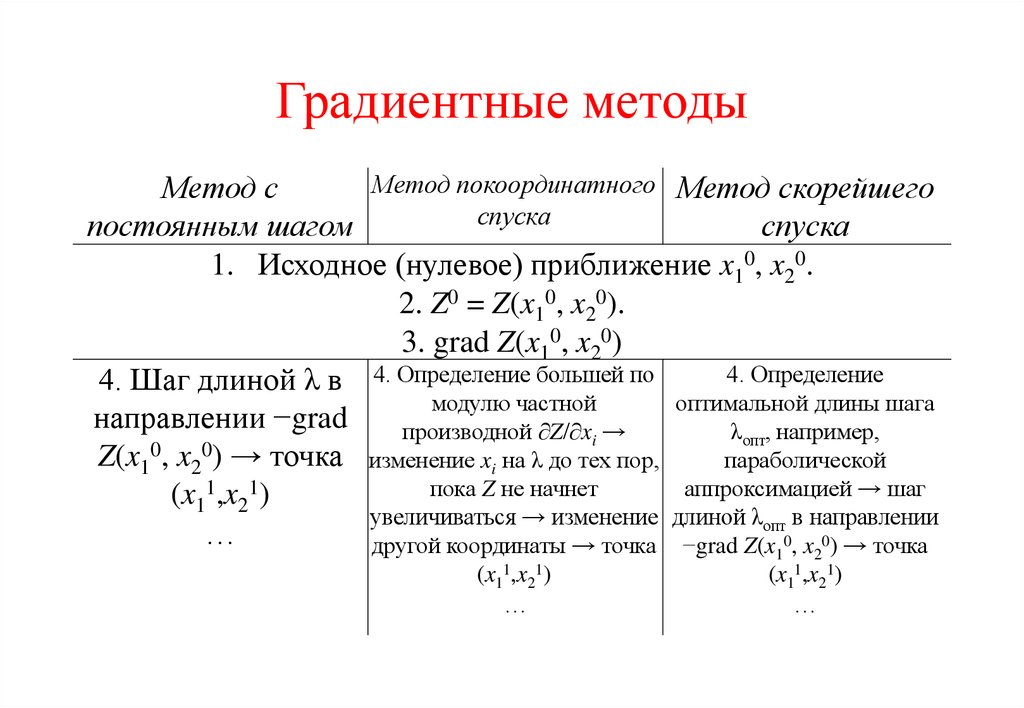

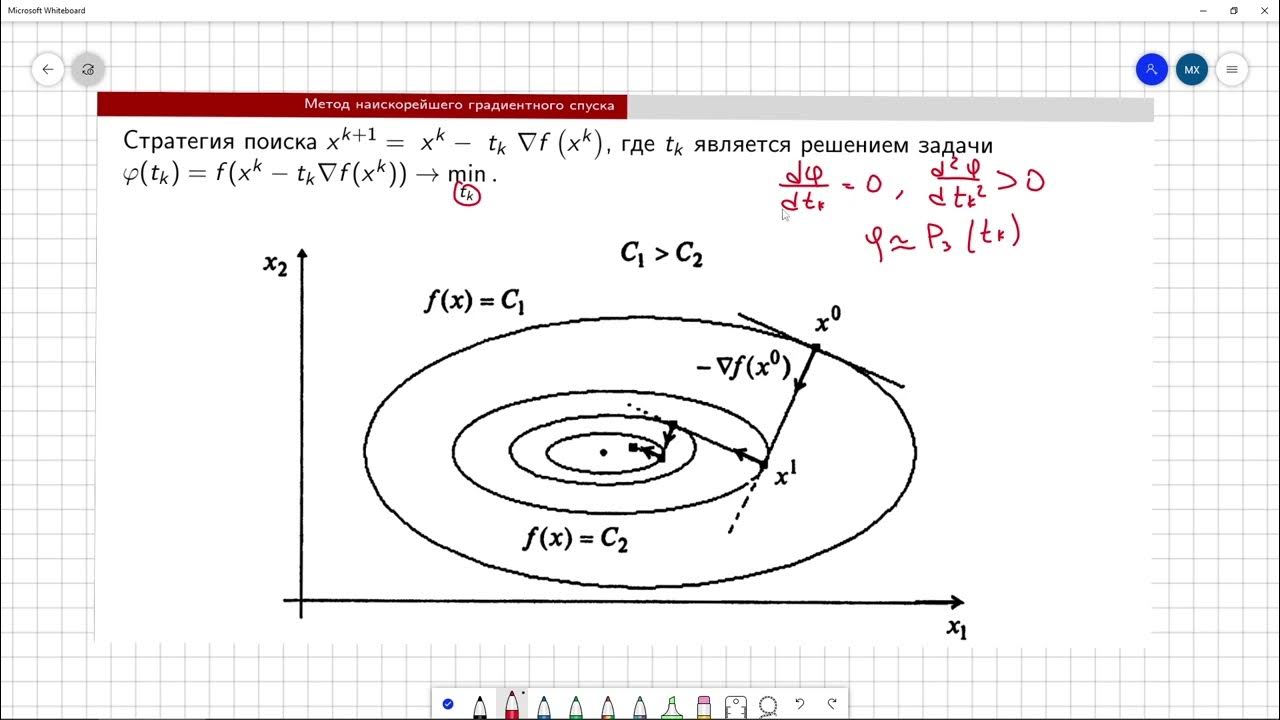

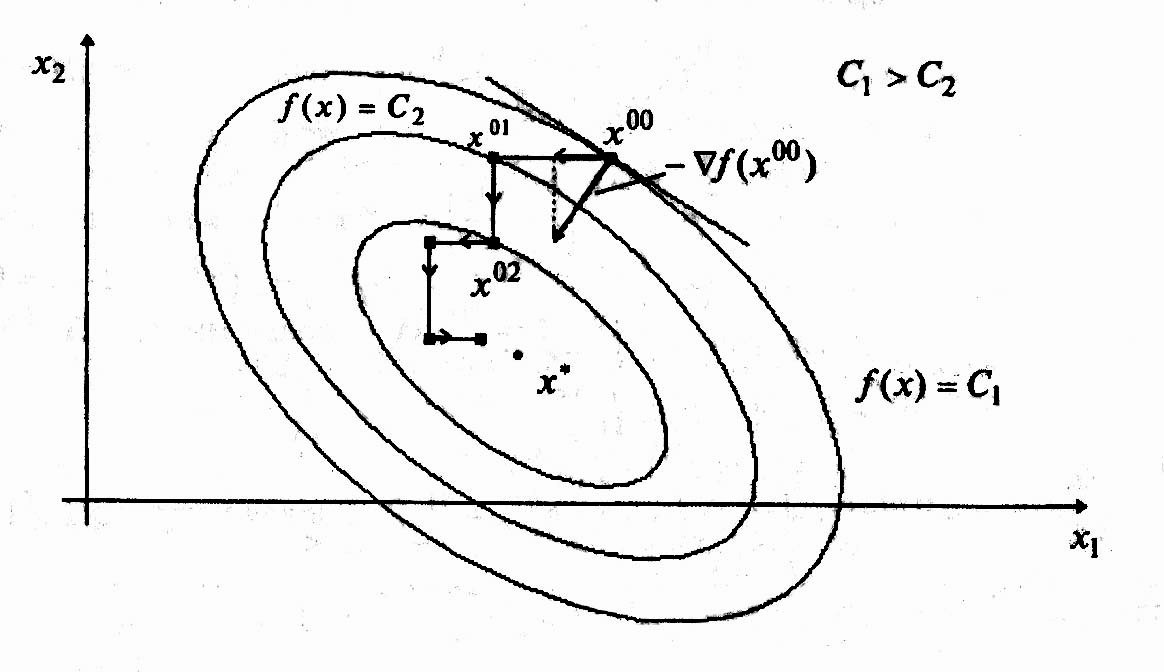

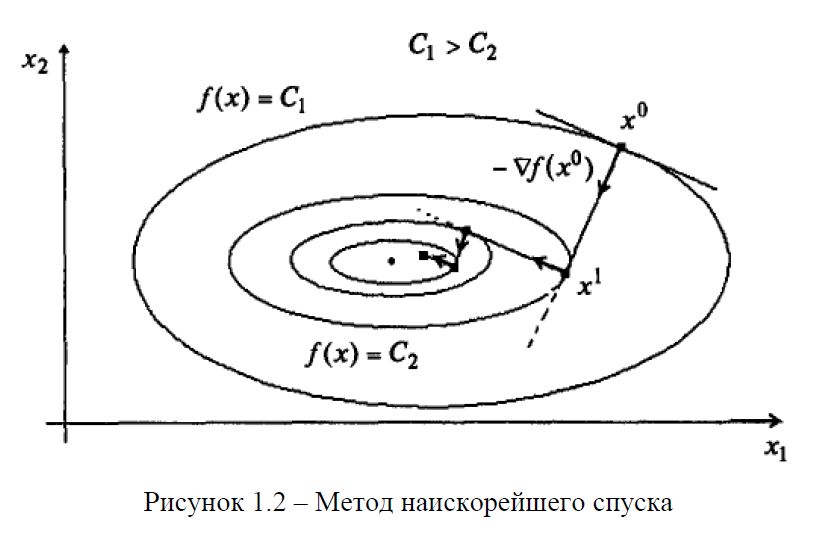

Методы оптимизации 7. Градиентный спуск

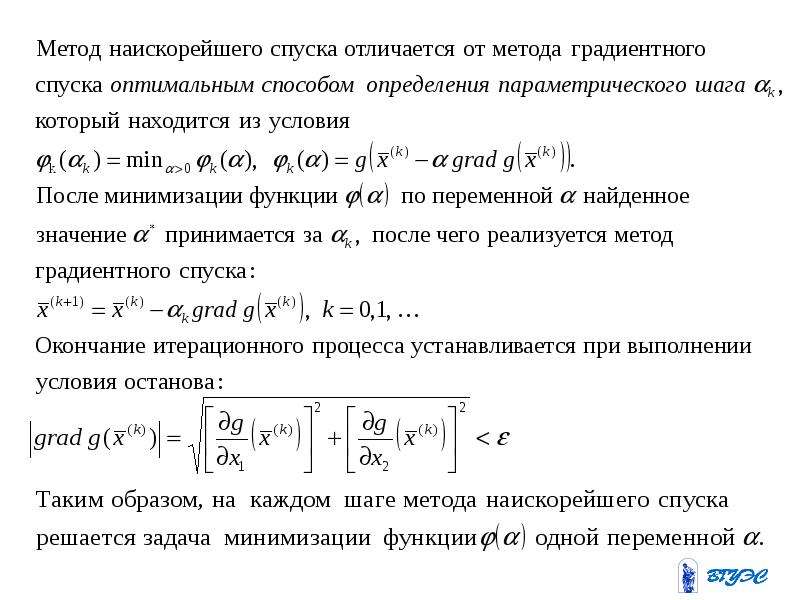

Используйте адаптивные методы, такие как Adam или Adagrad, чтобы автоматически подстраивать шаг обучения, что может ускорить процесс оптимизации.

Градиентный спуск на пальцах

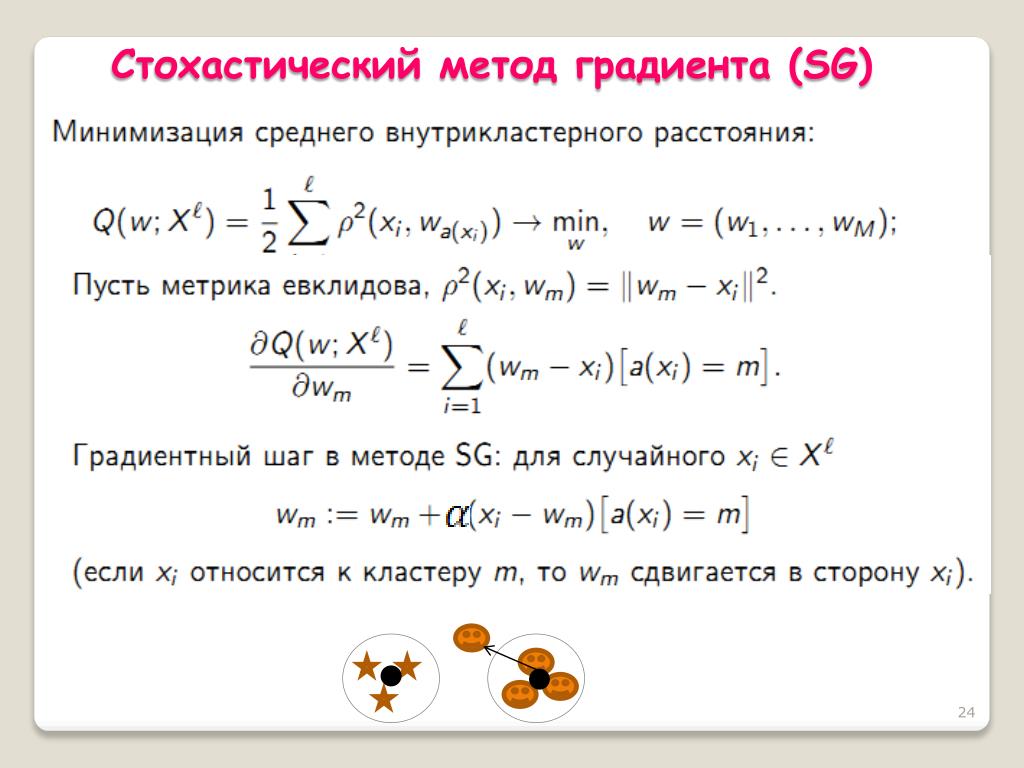

Для избежания проблем с локальными минимумами рекомендуется применять метод градиентного спуска с несколькими начальными точками (стартовыми значениями параметров) или использовать методы, такие как стохастический градиентный спуск (SGD).

ЦОС Python #3: Метод градиентного спуска для двух параметров

Важно следить за величиной градиента, так как в случае его переполнения или слишком малых значений может возникнуть проблема затухания или взрыва градиента.

ЦОС Python #2: Метод градиентного спуска

При работе с большими данными используйте мини-батчи, чтобы уменьшить вычислительную нагрузку и ускорить обучение модели без потери точности.

Методы оптимизации 3. Улучшения градиентного спуска

Регуляризация в градиентном спуске помогает предотвратить переобучение, добавляя штраф за слишком большие параметры модели. Это особенно важно для сложных моделей.

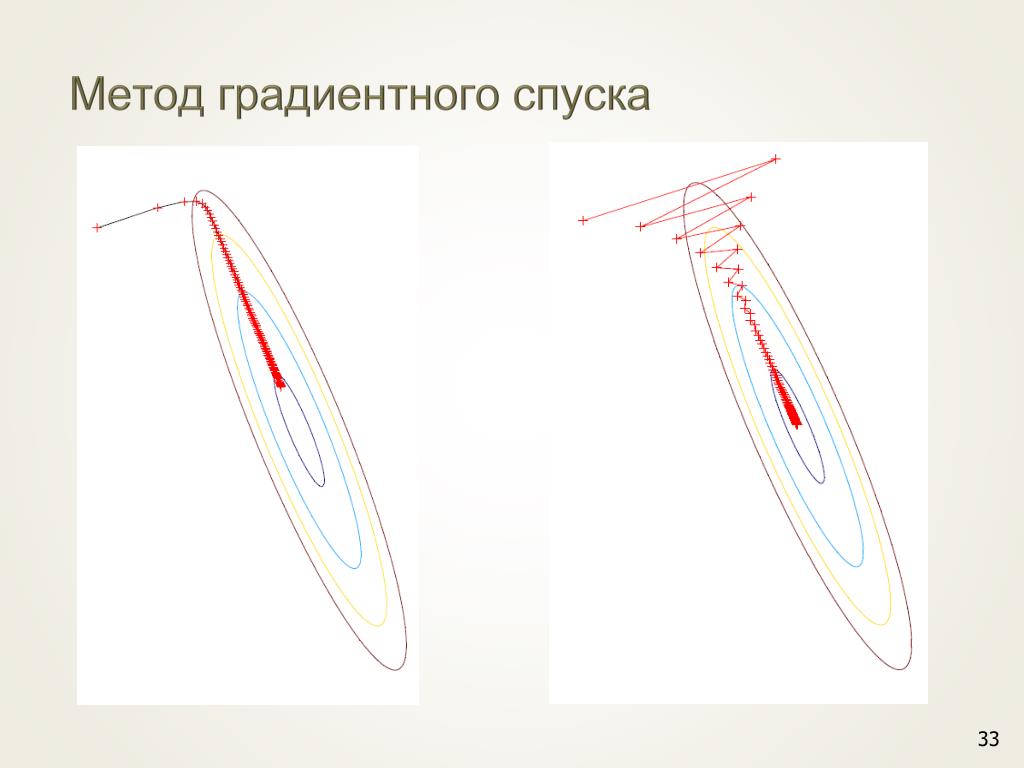

Оптимизация: метод градиентного спуска с постоянным шагом. Функция f(x, y) = x^2 + 9y^2, c = 14.

Используйте нормализацию данных перед применением градиентного спуска. Это поможет ускорить сходимость и уменьшить вероятность переполнения градиентов.

Графическое отображение функции потерь и процесса оптимизации поможет визуально отслеживать эффективность выбора гиперпараметров и настройки алгоритма.

ИМРС 4.3 Метод градиентного спуска

Если вам нужно улучшить производительность, попробуйте использовать градиентный спуск с моментумом, который помогает ускорить сходимость, добавляя инерцию в процесс оптимизации.

Лекция 2.4: Градиентный спуск.

Экспериментируйте с различными функциями потерь и их комбинациями, чтобы найти наиболее подходящие для вашей задачи, поскольку это сильно влияет на эффективность работы метода градиентного спуска.

Численные методы оптимизации 2. Градиентный спуск