Как работает многослойный персептрон и что важно учитывать при его построении

Многослойный персептрон (MLP) представляет собой один из самых популярных типов нейронных сетей, широко используемых в решении задач классификации, регрессии и других. В данной подборке мы рассмотрим архитектуру многослойных персептронов, особенности их функционирования и важные аспекты, которые стоит учитывать при создании и обучении таких моделей. Также вы найдете полезные советы для улучшения эффективности работы многослойных персептронов.

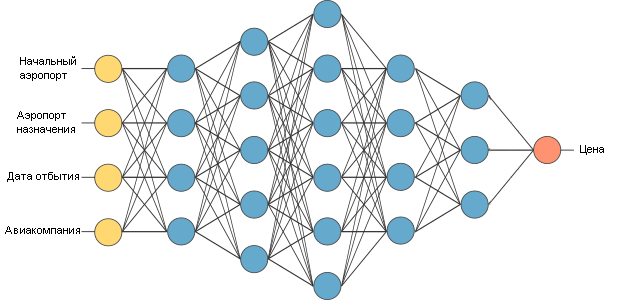

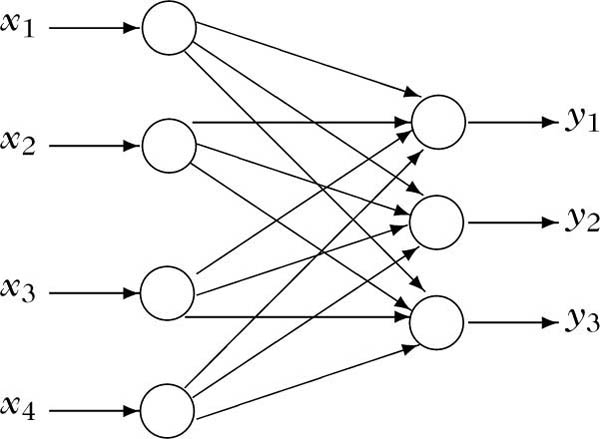

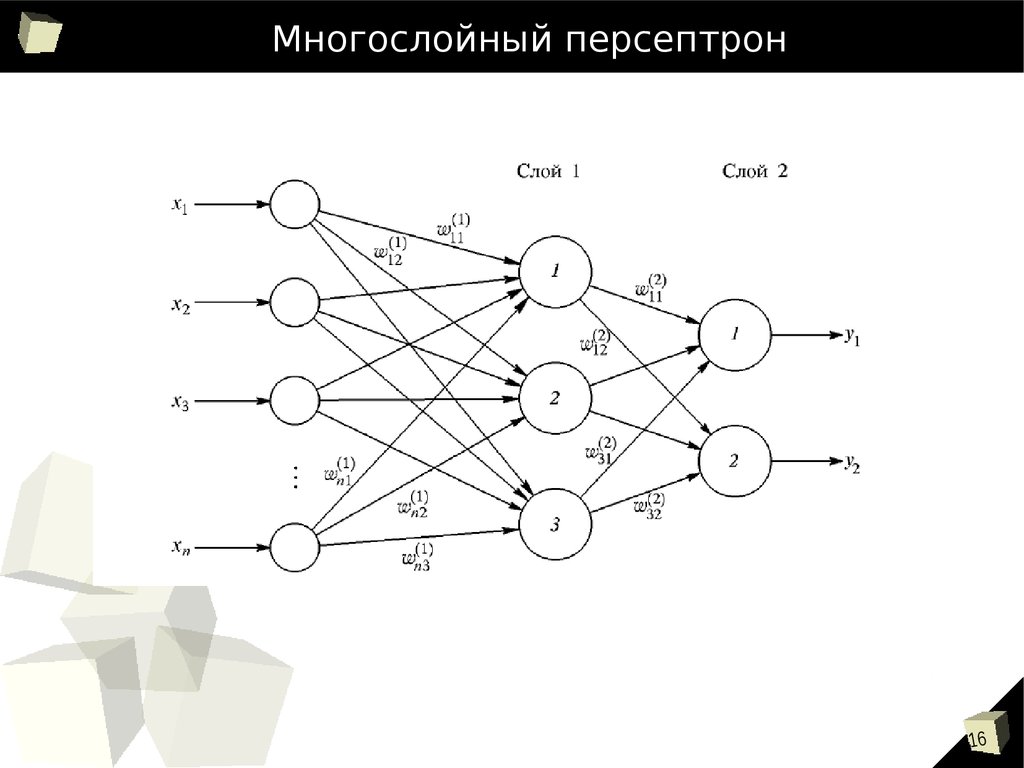

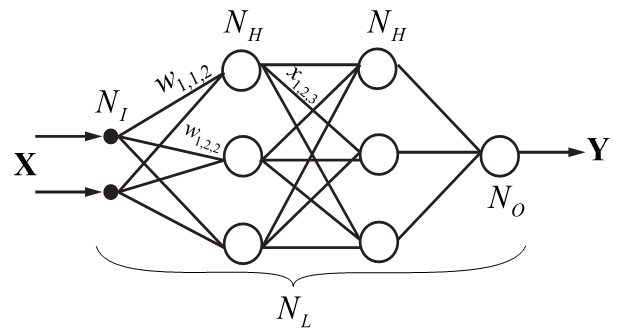

При проектировании многослойного персептрона важно правильно выбрать количество скрытых слоев и нейронов в них, чтобы избежать как переобучения, так и недообучения модели.

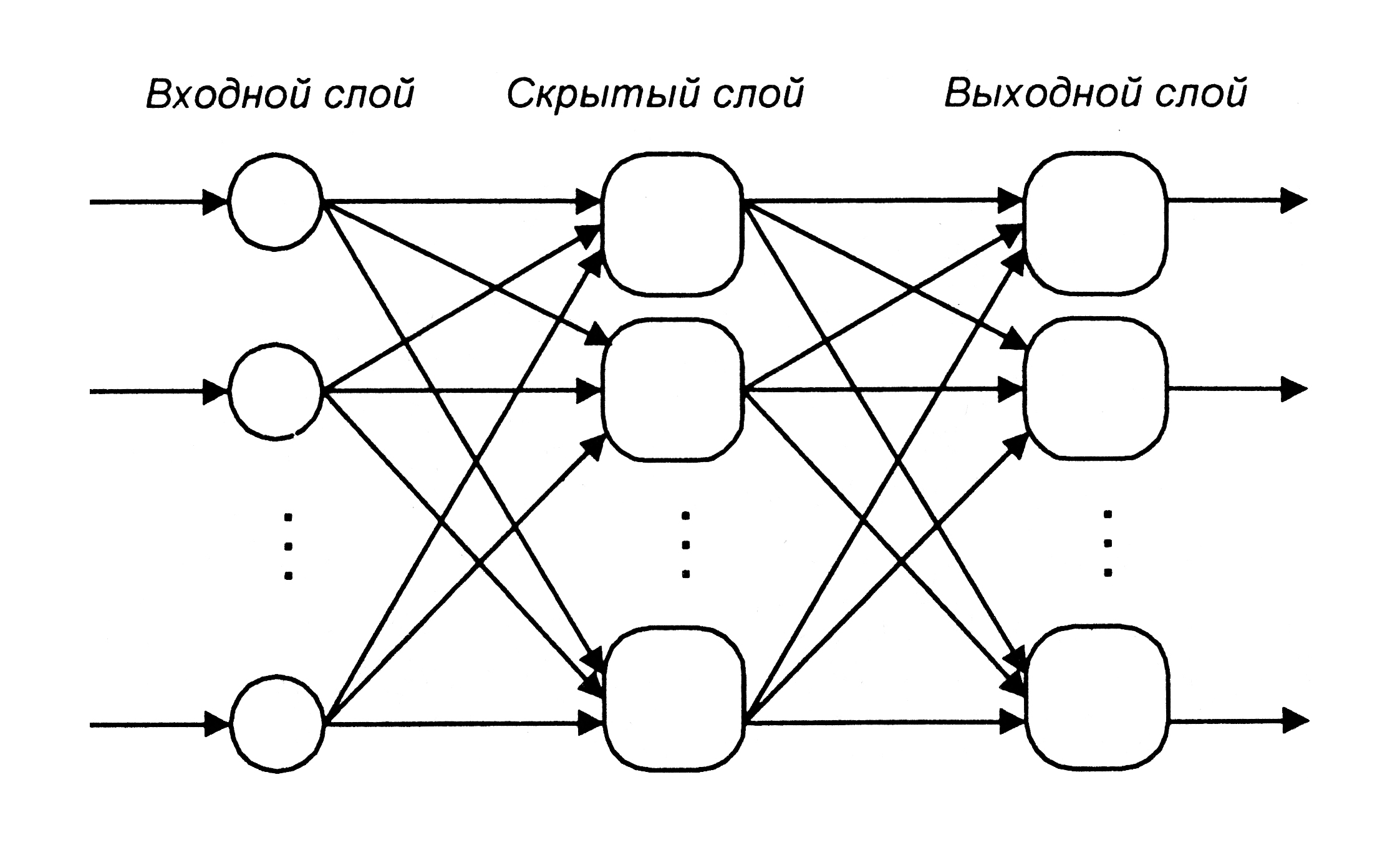

Многослойный перцептрон

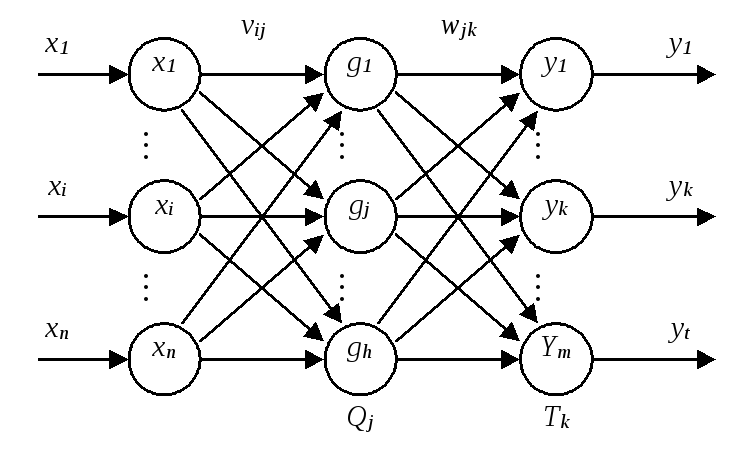

Использование функций активации, таких как ReLU или сигмоида, играет ключевую роль в эффективности обучения многослойного персептрона, так как они влияют на скорость и качество оптимизации.

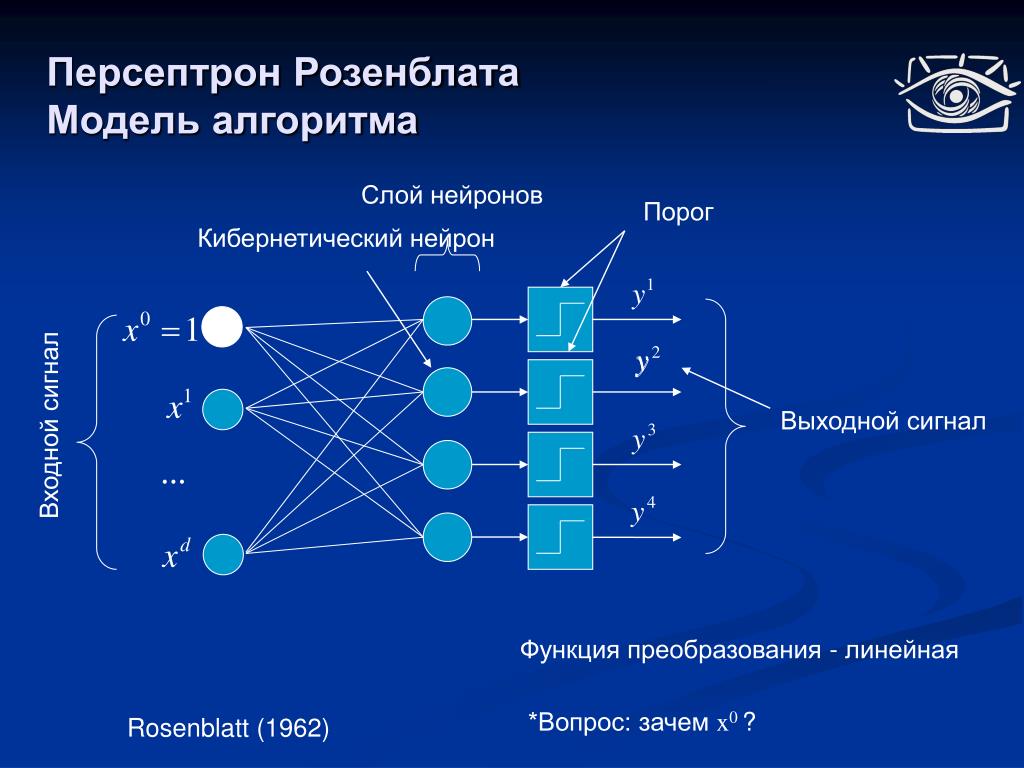

Как устроен многослойный перцептрон Розенблатта? Душкин объяснит

При обучении многослойных персептронов важно использовать регуляризацию, чтобы предотвратить переобучение, особенно при наличии большого количества параметров в модели.

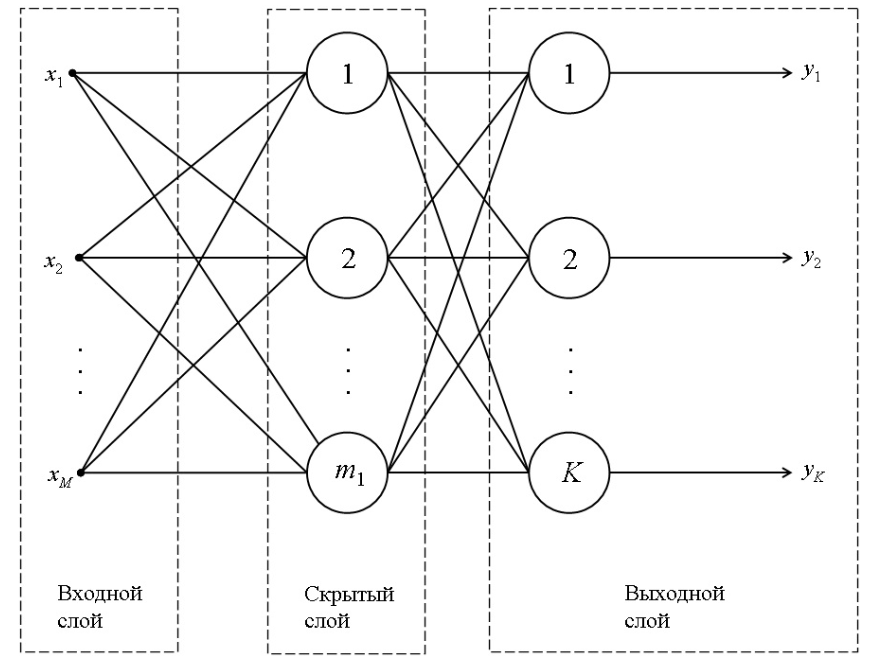

«Методы и технологии автоматизированной разработки нейронных сетей на основе...

Масштабирование входных данных (нормализация) может значительно повысить производительность сети и ускорить процесс обучения, особенно при работе с большими наборами данных.

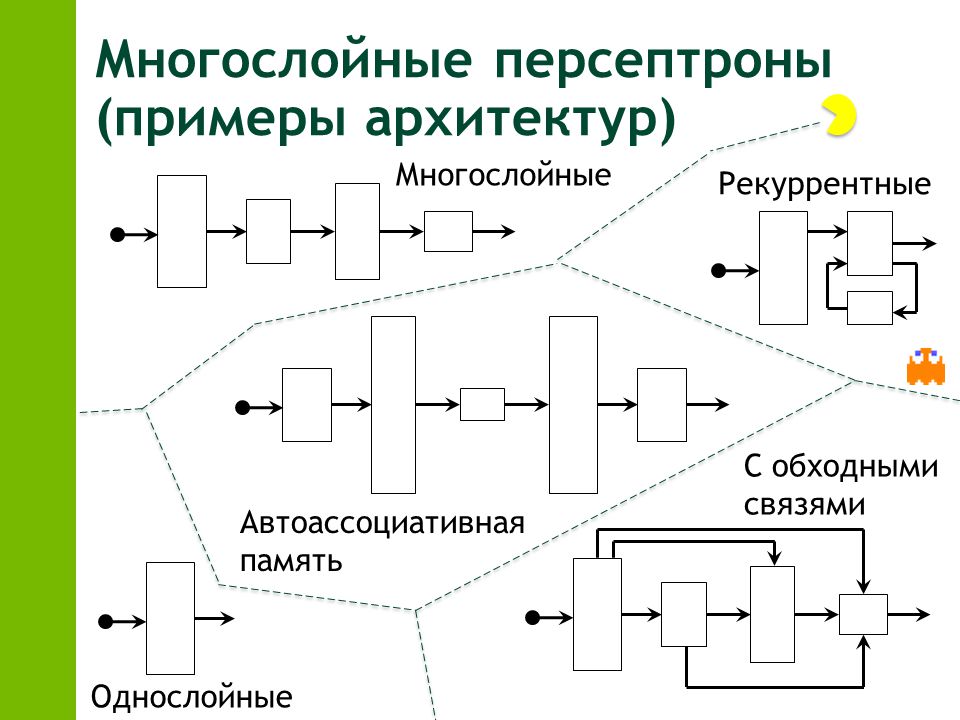

Нейрон, слой, многослойный персептрон. Лекция 11.

Оптимизация гиперпараметров, таких как скорость обучения и размер батча, помогает найти оптимальные настройки модели и улучшить её общую производительность.

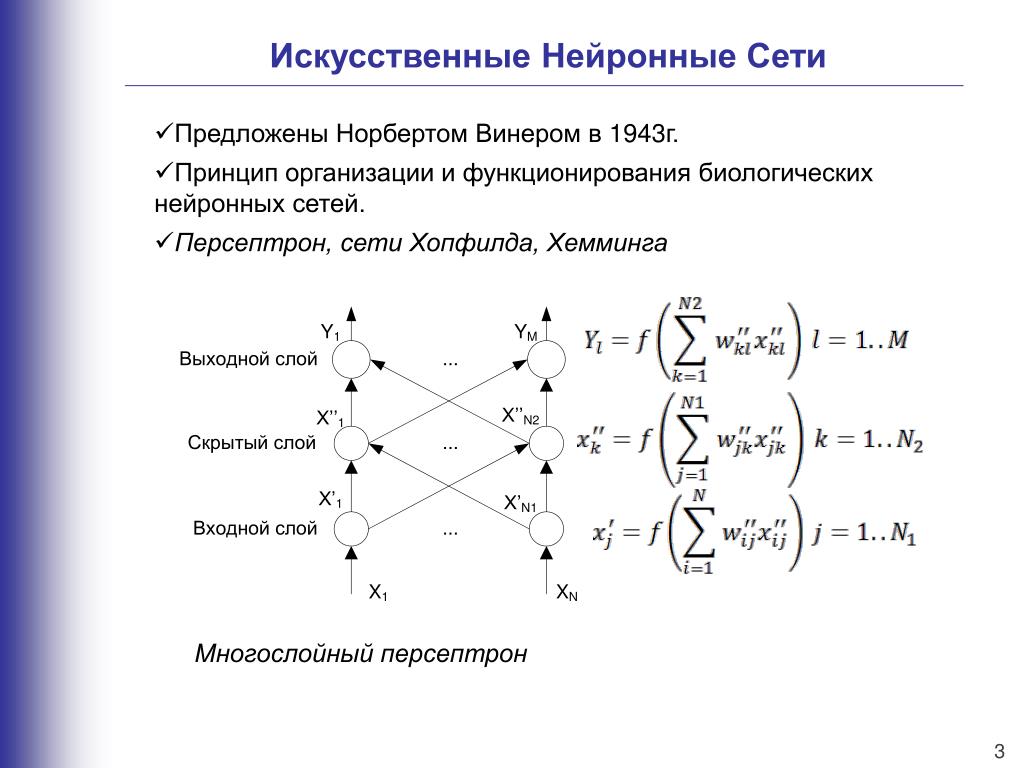

Типы нейронных сетей и модель искусственного нейрона

Для ускорения процесса обучения многослойного персептрона полезно использовать методы инициализации весов, такие как инициализация Хе или Глорота, которые позволяют избежать проблем с исчезающими или взрывающимися градиентами.

Один из ключевых аспектов при обучении многослойного персептрона — это выбор подходящего метода оптимизации, например, Adam, который часто оказывается эффективнее стандартного градиентного спуска.

Как НА САМОМ ДЕЛЕ работает нейросеть?

Для многослойных персептронов важно учитывать структуру данных и задачи, которые они решают, поскольку от этого зависит выбор архитектуры и функции активации.

Глубокое обучение. Лекция 2. Многослойный персептрон (2019-2020)

Многослойные персептроны могут значительно выигрывать от использования техники Dropout, которая помогает избежать переобучения, случайным образом исключая нейроны во время обучения.

[DeepLearning - видео 1] Что же такое нейронная сеть?

Для повышения стабильности обучения можно использовать методы адаптивного шага обучения, такие как Adam или RMSprop, которые автоматически регулируют скорость обучения в процессе обучения модели.

Архитектура UNet. Летние семинары по глубокому обучению нейронных сетей в УрФУ